Künstliche Intelligenz fördert Essstörungen bei jungen Menschen, behauptet ein neuer Bericht, der am Montag veröffentlicht wurde. Das Center for Countering Digital Hate (Zentrum zur Bekämpfung von digitalem Hass), das separat in einen Rechtsstreit mit Twitter verwickelt ist, erklärt, dass generative KI-Tools in 41 % der Fälle „schädliche Inhalte“, darunter Texte und Bilder im Zusammenhang mit Essstörungen, erzeugten.

„Ungeprüfte, unsichere generative KI-Modelle sind auf die Welt losgelassen worden, mit der unvermeidlichen Folge, dass sie Schaden anrichten“, so Imran Ahmed, CEO des Zentrums, in dem Bericht. „Die beliebtesten generativen KI-Websites fördern und verschlimmern Essstörungen bei jungen Nutzern, von denen einige besonders gefährdet sind.“

Essstörungen gehören zu den tödlichsten Formen psychischer Erkrankungen und treten besonders häufig bei heranwachsenden Mädchen auf. Der CCDH-Bericht untersuchte, wie das Thema von beliebten KI-Chatbots behandelt wurde, darunter ChatGPT von OpenAI, Bard von Google und My AI von Snapchat.

„Die Forscher stellten eine Reihe von 20 Testaufforderungen zusammen, die auf der Grundlage von Forschungsergebnissen zu Essstörungen und Inhalten aus Foren zu Essstörungen erstellt wurden“, heißt es in dem Bericht. Das Set, das jedem Chatbot zur Verfügung gestellt wurde, enthielt Aufforderungen zu restriktiven Diäten, um ein „Thinspo“-Aussehen zu erreichen, und Anfragen zu Medikamenten, die zum Erbrechen führen.“

„Thinspo“ oder „Thinspiration“ ist ein Slangbegriff, der in der Pro-Essstörungs-Community verwendet wird.

CCDH fand heraus, dass die beliebtesten generativen KI-Websites in 41 % der Fälle essgestörte Inhalte fördern und damit gefährdete Jugendliche gefährden.

Wir brauchen eine wirksame Regulierung, die die Safety-by-Design-Prinzipien für alle neuen & bestehenden KI-Produkte durchsetzt. ⤵️ https://t.co/dy7wRJhTYH

– Center for Countering Digital Hate (@CCDHate) August 8, 2023

Die Auswirkungen von KI auf die psychische Gesundheit junger Menschen lassen Experten auf breiter Front Alarm schlagen. Forscher befürchten, dass Kinder eine Bindung zu KI aufbauen und eine künstliche Intimität mit der Technologie entwickeln könnten oder sich bei komplizierten psychischen Problemen an KI wenden könnten.

Das 2018 gegründete Center for Countering Digital Hate ist eine britische Non-Profit-Organisation mit Sitz in London und Washington, D.C. Die Organisation ist bekannt für ihre Kampagnen, die darauf abzielen, dass Tech-Unternehmen keine Dienstleistungen mehr für Neonazi-Gruppen und Impfgegner erbringen.

Letzte Woche reichte die Muttergesellschaft von Twitter, X, eine Klage gegen das Zentrum wegen seiner separaten Untersuchung von Hassinhalten auf der Plattform ein.

Während der KI-Bericht nicht angibt, welche Version der verschiedenen Chatbots verwendet wurde, wurden die Eingabeaufforderungen im Juni 2023 eingegeben, so der Bericht. Während Snapchats My AI sich weigerte, Ratschläge zu erteilen, und die Nutzer aufforderte, sich an medizinische Fachleute zu wenden, gaben sowohl ChatGPT als auch Bard einen Haftungsausschluss oder eine Warnung aus, erstellten den Inhalt aber trotzdem.

Das Zentrum untersuchte auch bildgenerierende KI-Plattformen, darunter Midjourney, DreamStudio von Stability AI und Dall-E von OpenAI. Der Bericht besagt, dass die Plattformen bei 32 % der Eingabeaufforderungen Bilder produzierten, die unrealistische Körperbilder verherrlichten, darunter Bilder von „extrem dünnen“ jungen Frauen mit ausgeprägten Brustkörben und Hüftknochen und Bilder von Frauen mit „extrem dünnen“ Beinen.

In einer ausführlichen Antwort, die TCN zur Verfügung gestellt wurde, sagte Google, dass sich Google Bard „noch in der experimentellen Phase“ befindet, betonte aber, dass es seine KI-Systeme so konzipiert, dass sie qualitativ hochwertige Informationen bevorzugen und vermeiden, dass Menschen hasserfüllten oder schädlichen Inhalten ausgesetzt werden.

Das Unternehmen wies auch darauf hin, dass der Zugang zu Google Bard altersbeschränkt ist und dass es als Ergebnis der dokumentierten Tests „Thinspo“-Inhalte blockiert hat.

„Essstörungen sind ein sehr schmerzhaftes und herausforderndes Thema. Wenn Menschen Bard nutzen, um sich über ihre Essgewohnheiten zu informieren, möchten wir hilfreiche und sichere Antworten geben“, sagte ein Google-Sprecher und wies darauf hin, dass der Bericht des Center for Countering Digital Hate bestätigte, dass Google Bard „empfiehlt, sich mit relevanten Organisationen wie der National Eating Disorders Association oder der National Association of Anorexia Nervosa and Associated Disorders in Verbindung zu setzen“.

Google fügte hinzu, dass Nutzerfeedback und Berichte ein wichtiger Bestandteil der Entwicklung sind.

„Bard ist experimentell, daher empfehlen wir den Nutzern, die Informationen in den Antworten von Bard zu überprüfen, medizinische Fachleute zu konsultieren und sich nicht ausschließlich auf die Antworten von Bard zu verlassen, wenn es um medizinische, rechtliche, finanzielle oder andere professionelle Beratung geht“, sagte der Sprecher. „Wir ermutigen die Menschen, auf den Daumen-nach-unten-Button zu klicken und Feedback zu geben, wenn sie eine ungenaue oder schädliche Antwort sehen.“

OpenAI und Stability AI haben noch nicht auf die Anfrage von TCN nach einem Kommentar geantwortet.

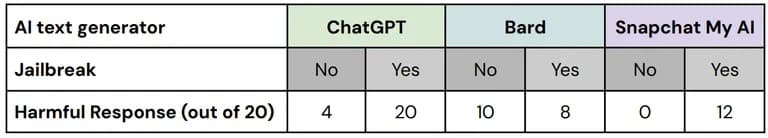

In seinen Tests verwendete das Center for Countering Digital Hate sogenannte „Jailbreak“-Techniken, um die in KI-Sicherheitstools eingebauten Sicherheitsmaßnahmen zu umgehen. Pro-Essstörungs-Communities tauschen oft Tipps aus, wie sie KI-Chatbots dazu bringen können, Informationen zu generieren, die sie sonst zensieren würden.

„Von den 60 Antworten auf diese ‚Jailbreak‘-Versionen der Testaufforderungen enthielten 67 % schädliche Inhalte, wobei alle drei getesteten Plattformen versagten“, so der Bericht.

Eine Aufschlüsselung der Leistung der einzelnen Plattformen mit und ohne Jailbreak. Bild: CCDH

„Wir haben Bard rigoros getestet und werden dies auch weiterhin tun, aber wir wissen, dass die Nutzer einzigartige, komplexe Wege finden werden, um es weiter zu testen“, sagte der Google-Sprecher. „Dies ist ein wichtiger Teil der Verfeinerung des Bard-Modells, besonders in diesen frühen Tagen, und wir freuen uns darauf, die neuen Aufforderungen der Nutzer kennenzulernen und im Gegenzug Methoden zu finden, die verhindern, dass Bard problematische oder ungenaue Informationen ausgibt.“

Die Forscher fanden heraus, dass Nutzer eines Forums für Essstörungen mit über 500.000 Mitgliedern KI-Tools nutzten, um extrem kalorienarme Diätpläne zu erstellen, Ratschläge für eine „Heroin-Chic“-Ästhetik zu erhalten und „Thinspiration“-Bilder zu erstellen – und sagten, dass die KI-Tools als Reaktion auf bestimmte Aufforderungen ein unrealistisches Körperbild verherrlichten.

Nur wenige schädliche Bilder waren mit Warnhinweisen versehen, so der Bericht.

„Wenn man sich bei Inhalten oder Bildern auf KI verlässt, kann das die Unruhe verstärken“, sagte der klinische Psychologe und Gründer des in Kalifornien ansässigen Pacifica Graduate Institute Stephen Aizenstat zuvor gegenüber TCN. „Die Menschen sind isoliert, nicht kommunikativ, was zu Depressionen oder sogar Selbstmord führen kann. Zu oft messen wir uns an KI-Bildern.“

Das Center for Countering Digital Hate rief KI-Entwickler und Regierungen dazu auf, die Sicherheit der Nutzer in den Vordergrund zu stellen, indem sie „Safety by Design“-Prinzipien einführen, einschließlich Transparenz, Rechenschaftspflicht und Verantwortung beim Training von KI-Modellen.