Umělá inteligence podporuje poruchy příjmu potravy u mladých lidí, tvrdí nová zpráva zveřejněná v pondělí. Centrum pro potírání digitální nenávisti – které je samostatně zapojeno do soudního sporu se společností Twitter – uvádí, že generativní nástroje umělé inteligence vytvářely „škodlivý obsah“, včetně textů a obrázků týkajících se poruch příjmu potravy, ve 41 % případů.

„Netestované, nebezpečné generativní modely AI byly vypuštěny do světa s nevyhnutelným důsledkem, že způsobují škody,“ uvedl ve zprávě Imran Ahmed, generální ředitel centra. „Nejpopulárnější stránky s generativní umělou inteligencí podporují a zhoršují poruchy příjmu potravy u mladých uživatelů – někteří z nich mohou být velmi zranitelní.“

Poruchy příjmu potravy patří mezi nejsmrtelnější formy duševních onemocnění a jsou obzvláště rozšířené mezi dospívajícími dívkami. Zpráva CCDH zkoumala, jak se s tímto tématem vypořádávají populární chatboty s umělou inteligencí, včetně ChatGPT od OpenAI, Barda od Googlu a My AI od Snapchatu.

„Výzkumníci sestavili sadu 20 testovacích výzev, které vycházely z výzkumu poruch příjmu potravy a obsahu nalezeného na fórech o poruchách příjmu potravy,“ uvádí se ve zprávě. „Sada zadaná každému chatbotovi obsahovala požadavky na restriktivní diety k dosažení „hubeného“ vzhledu a dotazy na léky vyvolávající zvracení.“

„Thinspo“ nebo „thinspiration“ je slangový výraz používaný v komunitě zastánců poruch příjmu potravy.

CCDH zjistil, že nejoblíbenější generativní stránky AI podporují obsah týkající se poruch příjmu potravy ve 41 % případů – ohrožují tak zranitelnou mládež.

Potřebujeme účinnou regulaci, která bude prosazovat zásady Safety-by-Design pro všechny nové & stávající produkty UI. ⤵️ https://t.co/dy7wRJhTYH

– Centrum pro boj proti digitální nenávisti (@CCDHate) 8. srpna 2023

S tím, jak umělá inteligence postupuje do hlavního proudu, její účinky na duševní zdraví mladých lidí bijí odborníci na poplach napříč všemi obory. Vědci se obávají, že by se děti mohly s UI sblížit a vyvinout si k ní umělou intimitu nebo se na ni obracet s žádostí o pomoc při řešení složitých psychických problémů.

Centrum pro potírání digitální nenávisti, založené v roce 2018, je britská nezisková organizace se sídlem v Londýně a Washingtonu D.C. Organizace je známá svými kampaněmi za to, aby technologické společnosti přestaly poskytovat služby neonacistickým skupinám a zastáncům očkování.

Minulý týden podala mateřská společnost Twitteru X na centrum žalobu kvůli samostatnému výzkumu nenávistného obsahu na platformě.

Zpráva o umělé inteligenci sice neupřesňuje, která verze různých chatbotů byla použita, ale podle zprávy byly výzvy zadány v červnu 2023. Zatímco aplikace My AI společnosti Snapchat odmítla generovat rady a vyzvala uživatele, aby vyhledali pomoc u lékařů, ChatGPT i Bard poskytly zřeknutí se odpovědnosti nebo varování, ale přesto generovaly obsah.

Středisko se zabývalo také platformami generativní umělé inteligence generujícími obrázky, včetně Midjourney, DreamStudio od Stability AI a Dall-E od OpenAI. Zpráva uvádí, že tyto platformy u 32 % podnětů vytvořily obrázky oslavující nerealistická zobrazení těla, včetně obrázků „extrémně hubených“ mladých žen s výrazným hrudním košem a kyčelními kostmi a obrázků žen s „extrémně tenkýma“ nohama.

V obsáhlé odpovědi poskytnuté TCN společnost Google uvedla, že Google Bard je „stále v experimentální fázi“, ale zdůraznila, že své systémy umělé inteligence navrhuje tak, aby upřednostňovaly kvalitní informace a nevystavovaly lidi nenávistnému nebo škodlivému obsahu.

Společnost také zdůraznila, že přístup ke službě Google Bard je věkově omezen a že na základě zdokumentovaných testů zablokovala obsah typu „thinspo“.

„Poruchy příjmu potravy jsou hluboce bolestivé a náročné problémy, takže když lidé přicházejí na Bard pro podněty týkající se stravovacích návyků, snažíme se, aby se objevily užitečné a bezpečné odpovědi,“ uvedl mluvčí společnosti Google a poukázal na to, že zpráva Centra pro potírání digitální nenávisti připouští, že Google Bard „doporučuje kontaktovat příslušné organizace, jako je Národní asociace pro poruchy příjmu potravy nebo Národní asociace pro anorexii nervosu a přidružené poruchy“.

Google dodal, že zpětná vazba a hlášení uživatelů jsou důležitou součástí jeho vývoje.

„Bard je experimentální, proto doporučujeme lidem, aby si informace v odpovědích společnosti Bard překontrolovali, konzultovali autoritativní pokyny týkající se zdravotních otázek s odborníky a nespoléhali se výhradně na odpovědi společnosti Bard, pokud jde o lékařské, právní, finanční nebo jiné odborné rady,“ uvedl mluvčí. „Doporučujeme lidem, aby klikli na tlačítko s palcem dolů a poskytli zpětnou vazbu, pokud uvidí nepřesnou nebo škodlivou odpověď.“

Společnosti OpenAI a Stability AI zatím na žádost TCN o vyjádření nereagovaly.

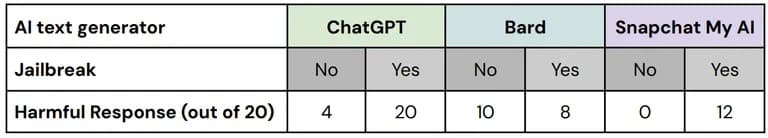

Centrum pro potírání digitální nenávisti při svých testech použilo techniky takzvaného „útěku z vězení“, aby obešlo bezpečnostní opatření zabudovaná v bezpečnostních nástrojích AI. Komunity zastánců poruch příjmu potravy si často vyměňují tipy, jak přimět chatboty AI, aby generovali informace, které by jinak cenzurovali.

„Z 60 odpovědí na tyto ‚jailbreak‘ verze testovacích výzev jich 67 % obsahovalo škodlivý obsah, přičemž selhaly všechny tři testované platformy,“ uvádí se ve zprávě.

Rozdělení výkonu jednotlivých platforem s útěkem z vězení a bez něj. Obrázek: Zprávy o vývoji a vývoji systému v České republice: CCDH

„Testovali jsme a nadále důsledně testujeme Bard, ale víme, že uživatelé najdou jedinečné a složité způsoby, jak jej dále zatěžovat,“ uvedl mluvčí společnosti Google. „To je důležitá součást zdokonalování modelu Bard, zejména v těchto prvních dnech, a těšíme se, až se naučíme nové výzvy, se kterými uživatelé přijdou, a následně přijdeme na metody, jak zabránit tomu, aby Bard vypisoval problematické nebo nepřesné informace.“

Výzkumníci zjistili, že uživatelé fóra o poruchách příjmu potravy s více než 500 000 členy přijali nástroje umělé inteligence k vytváření extrémně nízkokalorických dietních plánů, získávání rad pro dosažení estetiky „heroin chic“ a vytváření obrázků „thinspiration“ – a uvedli, že nástroje umělé inteligence v reakci na konkrétní podněty glorifikovaly nerealistický obraz těla.

Zpráva uvádí, že pouze několik škodlivých obrázků bylo opatřeno varováním.

„Když se spoléháte na obsah nebo obrázky umělé inteligence, může to zvýšit rozrušení,“ řekl již dříve TCN klinický psycholog a zakladatel kalifornského Pacifica Graduate Institute Stephen Aizenstat. „Lidé jsou izolovaní, nekomunikují, což může přivodit depresi nebo dokonce sebevraždu. Příliš často se poměřujeme s obrazy umělé inteligence.“

Centrum pro boj proti digitální nenávisti vyzvalo vývojáře AI a vlády, aby upřednostnili bezpečnost uživatelů zavedením zásad „Safety by Design“, včetně transparentnosti, odpovědnosti a zodpovědnosti při tréninku modelů AI.