In der sich ständig weiterentwickelnden Welt der Technik schlagen die Bemühungen von Elon Musk selten keine Wellen. Wenige Wochen nach seinem Aufruf, die Ausbildung von LLMs, die fähiger sind als GPT-4, zu stoppen, hat Musk seinen typischen Zug gemacht: Er hat genau das Gegenteil von dem getan, was er gepredigt hat. Hier kommt xAI – Musks neuestes Geistesprodukt – und Grok, sein brandneues LLM, das am Samstag angekündigt wurde:

Ankündigung von Grok!

Grok ist eine KI nach dem Vorbild von Per Anhalter durch die Galaxis, die so gut wie alles beantworten kann und, was noch viel schwieriger ist, sogar vorschlägt, welche Fragen man stellen sollte!

Grok wurde entwickelt, um Fragen mit ein wenig Witz zu beantworten und hat eine rebellische Ader, also benutzen Sie bitte nicht…

– xAI (@xai) November 5, 2023

Das Projekt machte Schlagzeilen, nicht nur wegen der Beteiligung von Musk, sondern auch wegen der hochkarätigen Besetzung von Spitzen-KI-Forschern, die das Unternehmen von führenden Start-ups und Tech-Giganten gewinnen konnte. xAI wurde mit der verlockenden Aussicht auf eine KI beworben, die „die Welt verstehen“ soll, hielt sich aber geheimnisvoll bedeckt, was das „Wie“ und „Was“ seiner Operationen angeht… zumindest bis letzte Woche.

Ist dies ein weiterer klassischer Schachzug von Musk, um den Status quo in Frage zu stellen, oder nur ein überbewerteter Chatbot, der auf der massiven Welle der Popularität und des Hypes um seine Vorgänger reitet?

Das Gute

Ein konstanter Strom von Wissen in Echtzeit

Der Zugriff auf den gesamten Twitter-Inhaltsstrom macht Grok zu einem potenziellen Wegbereiter. Wie xAI hervorhob, verfügt Grok über ein „Echtzeit-Wissen über die Welt“, das KI-Forscher als Reinforcement Learning from Human Feedback (RLHF) bezeichnen und das Nachrichten und verschiedene Kommentare zu aktuellen Ereignissen verarbeitet.

Durch das Lernen von Ereignissen aus verschiedenen Blickwinkeln und die Aufnahme von Notizen aus der Twitter-Community – die im Wesentlichen aus Kommentaren bestehen – wird Grok von einer vielschichtigen Sicht auf die Welt profitieren.

Jüngsten Studien zufolge haben die Menschen ihr Verhalten bereits dahingehend geändert, dass sie zuerst in den sozialen Medien nach Nachrichten suchen, bevor sie sich den Mainstream-Medien zuwenden. Die Integration von Grok in Twitter könnte diesen Prozess weiter beschleunigen und den Nutzern unmittelbare Kommentare, Kontext und – bei guter Ausführung – Faktenüberprüfung vor Ort bieten. Wie xAI hervorhob, sorgt die Echtzeit-Wissensfunktion dafür, dass Grok immer am Puls der Welt ist und zeitnahe und relevante Antworten geben kann

Fun Mode: Elon’s dream made real

Elon Musks Vision einer lebenslustigen KI scheint mit dem so genannten „Fun Mode“ von Grok zum Leben erweckt worden zu sein. Diese Funktion ermöglicht es dem LLM, Witze zu machen, humorvolle und dennoch sachlich korrekte Antworten zu geben und den Nutzern eine lustige und lockere Konversationserfahrung zu bieten.

Eine der Herausforderungen bei bestehenden LLMs wie ChatGPT besteht darin, dass einige Nutzer das Gefühl haben, dass sie zu sehr bereinigt wurden, um politische Korrektheit zu gewährleisten, wodurch Interaktionen möglicherweise weniger organisch und spontan sind. Außerdem sind einige lokalisierte LLMs nicht für längere Interaktionen geeignet. Grok verspricht, mit seinem Spaßmodus diese Lücke zu schließen und als ansprechender Zeitvertreib für diejenigen zu dienen, die sich entspannen wollen.

Grok hat über die -Plattform Zugang zu Informationen in Echtzeit, was ein großer Vorteil gegenüber anderen Modellen ist.

Es basiert auch auf & liebt Sarkasmus. Ich habe keine Ahnung, wer es so geführt haben könnte ♂️ pic.twitter.com/e5OwuGvZ3Z

– Elon Musk (@elonmusk) November 4, 2023

Dieses Konzept ist nicht völlig neu, denn Poe von Quora bietet mit seinen fein abgestimmten Chatbots, von denen jeder eine eigene Persönlichkeit hat, einen ähnlichen Dienst. Die Einbettung in ein LLM mit den Fähigkeiten von Grok hebt das Erlebnis jedoch auf eine neue Ebene.

Nativer Internetzugang

Eines der weiteren Unterscheidungsmerkmale von Grok ist die Fähigkeit, auf das Internet zuzugreifen, ohne ein Plug-in oder ein anderes Modul zu benötigen.

Der genaue Umfang der Browsing-Fähigkeiten muss zwar noch geklärt werden, aber die Idee ist verlockend. Stellen Sie sich ein LLM vor, das die faktische Genauigkeit verbessern kann, weil es Daten in Echtzeit mit Querverweisen versehen kann. In Verbindung mit seinem Zugang zu Twitter-Inhalten könnte Grok die Art und Weise revolutionieren, wie Nutzer mit KI interagieren, da sie wissen, dass die Informationen, die sie erhalten, nicht nur auf bereits vorhandenen Trainingsdaten beruhen, sondern ständig aktualisiert und überprüft werden.

Multitasking

Grok ist Berichten zufolge multitaskingfähig und ermöglicht es den Nutzern, mehrere Gespräche gleichzeitig zu führen. Die Nutzer können verschiedene Themen erkunden, auf eine Antwort in einem Thread warten und mit einem anderen fortfahren.

Der Chatbot bietet auch die Möglichkeit, in Unterhaltungen zu verzweigen, so dass Benutzer tiefer in bestimmte Bereiche eindringen können, ohne die Hauptdiskussion zu unterbrechen, und bietet einen visuellen Leitfaden für alle Unterhaltungszweige, so dass Benutzer leicht zwischen Themen navigieren können.

Grok bietet auch einen integrierten Markdown-Editor, mit dem die Nutzer die Antworten von Grok herunterladen, bearbeiten und für die spätere Verwendung formatieren können. Dieses Tool in Kombination mit der Verzweigung stellt sicher, dass die Benutzer mit bestimmten Konversationszweigen arbeiten und nahtlos wieder einsteigen können.

Dies sind einige der UI-Funktionen von Grok. Erstens ermöglicht es Ihnen Multitasking. Sie können mehrere gleichzeitige Unterhaltungen führen und zwischen ihnen wechseln, während sie fortschreiten. pic.twitter.com/aXAG0M2oPF

– Toby Pohlen (@TobyPhln) November 5, 2023

Minimalzensur: eine frei sprechende KI

Elon Musks Vision für Grok war klar: eine KI, die sich nicht scheut, ihre digitale Meinung zu sagen.

Obwohl alle großen KI-Chatbots über Leitplanken verfügen, um potenziellen Schaden oder Fehlinformationen zu vermeiden, kann sich dies manchmal einschränkend anfühlen. Nutzer haben festgestellt, dass Modelle wie ChatGPT, Llama und Claude sich mit Antworten zurückhalten, um potenzielle Beleidigungen zu vermeiden. Dadurch werden jedoch möglicherweise Antworten herausgefiltert, die harmlos oder wirklich erwünscht sind.

Grok hat mehr Freiheiten bei seinen Antworten und kann daher möglicherweise eine authentischere und uneingeschränktere Konversationserfahrung bieten. Wie xAI hervorhebt, ist Grok aufgrund seines Designs in der Lage, auf pikante Fragen einzugehen, die andere KI-Systeme möglicherweise umgehen würden.

Ankündigung von Grok!

Grok ist eine KI nach dem Vorbild von Per Anhalter durch die Galaxis, die fast alles beantworten kann und, was noch viel schwieriger ist, sogar vorschlägt, welche Fragen man stellen sollte!

Grok wurde entwickelt, um Fragen mit ein wenig Witz zu beantworten und hat eine rebellische Ader, also benutzen Sie bitte nicht…

– xAI (@xai) November 5, 2023

Es ist offensichtlich, dass diese KI eine einzigartige Mischung aus Echtzeitinformationen, Humor, Genauigkeit und Freiheit bietet. Doch wie bei jeder Innovation gibt es auch hier Herausforderungen und potenzielle Fallstricke zu beachten.

Das Schlechte

Überstürzte Entwicklung und begrenzte Ausbildung

Die rasante Entwicklung von Grok hat von Anfang an einige Augenbrauen aufgeworfen. Wie xAI erklärte, „ist Grok noch ein sehr frühes Betaprodukt – das Beste, was wir mit zwei Monaten Schulung erreichen konnten“. In der Welt der LLMs klingen zwei Monate und 33 Milliarden Parameter wie ein Tropfen auf den heißen Stein.

Zum Vergleich: OpenAI hat seinen Entwicklungsprozess transparent dargestellt und erwähnt: „Wir haben sechs Monate damit verbracht, GPT-4 iterativ abzustimmen.“ Die unterschiedlichen Entwicklungszeiten lassen vermuten, dass die Entwicklung von Grok überstürzt wurde, um auf der Hype-Welle der KI mitzureiten.

Darüber hinaus hält sich x.AI über das Ausmaß der beim Training von Grok verwendeten Hardware bedeckt und lässt Raum für Spekulationen.

Alles über die Parameter

Für Uneingeweihte stellen die Parameter in LLMs die Menge an Informationen oder Wissen dar, die das Modell speichern kann. Sie geben die effektive Gehirnkapazität der KI an und bestimmen ihre Fähigkeit, Informationen zu verarbeiten und zu erzeugen. Grok mit seinen 33 Milliarden Parametern mag auf den ersten Blick beeindruckend klingen.

In der wettbewerbsorientierten LLM-Landschaft ist es jedoch nur ein weiterer Akteur. In der Tat könnte die Anzahl der Parameter nicht ausreichen, um komplexe Unternehmensanforderungen zu erfüllen und die qualitativ hochwertigen Ergebnisse zu liefern, die Titanen wie ChatGPT, Claude und Bard als Goldstandard gesetzt haben.

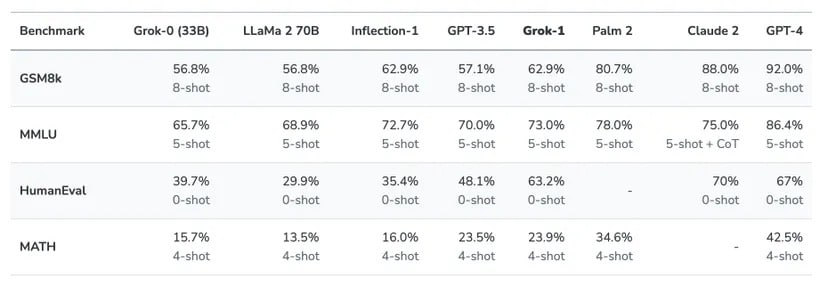

Zum Teil ist diese geringe Anzahl an Parametern der Grund, warum Grok andere Mainstream-Modelle in wichtigen Benchmarks wie HumanEval oder MMLU:

nicht schlagen kann.

Quelle: x.AI

Neben der Anzahl der Parameter stellt sich auch die Frage nach dem Umgang mit dem Kontext, d.h. wie viele Informationen ein KI-Chatbot in einer Eingabe verstehen kann. Grok ist in diesem Bereich nicht besonders beeindruckend. Laut xAI versteht Grok 8.192 Kontext-Token, aber GPT-4 jongliert mit satten 32.000, und Claude geht sogar noch weiter mit bis zu 100.000 Token. OpenAIs neuer GPT-4 Turbo erreicht ein Kontextfenster von 128.000 Token

Der Preis der Innovation

Die Kosten sind ein entscheidender Faktor bei der Beurteilung des Wertes eines jeden Produktes, und Grok bildet da keine Ausnahme. Der Chatbot wird Nutzern zur Verfügung stehen, die bereit sind, 16 Dollar pro Monat für das Privileg zu zahlen, mit ihm zu interagieren.

Angesichts kostenloser Angebote wie Claude 2 und ChatGPT, die mit GPT-3.5 Turbo ausgestattet sind, könnte Grok schwer zu verkaufen sein – vor allem, wenn man bedenkt, dass diese kostenlosen Modelle für ihre Genauigkeit angepriesen wurden und Grok in bestimmten Benchmarks bereits überholt haben.

Darüber hinaus verspricht sogar das leistungsfähigste LLM, GPT-4, besser zu sein als Grok, mit dem zusätzlichen Vorteil, dass es weithin zugänglich, multimodal und leistungsstark ist.

Der @xAI Grok AI-Assistent wird als Teil von Premium+ angeboten, daher empfehle ich, sich dafür anzumelden.

Nur $16/Monat über das Internet. https://t.co/wEEIZNjEkp

– Elon Musk (@elonmusk) November 4, 2023

Könnte die Einführung von Grok vor allem ein strategischer Schachzug sein, um die Abonnements für Twitter Blue anzukurbeln und damit die Einnahmequellen von Twitter zu erweitern?

Diese Bedenken machen deutlich, wie schwierig es für Grok ist, sich als wichtiger Akteur im LLM-Bereich zu etablieren. Und die Nachteile beschränken sich nicht nur auf den Preis:

Das Hässliche

Auslassung der Fiktion

Einen LLM auf eine fiktive Figur aus einem populären Roman zu gründen, ist zweifellos eine kreative Entscheidung. Auch wenn der Charme einer fiktiven Persönlichkeit verlockend sein mag, birgt er in einer Welt, die zunehmend auf genaue Informationen angewiesen ist, Risiken. Nutzer, die sich mit ernsthaften Fragen oder Ratschlägen an KI wenden, könnten mit einem System in Konflikt geraten, das eine komödiantische Figur nachahmt.

Da die Grenze zwischen Fiktion und Realität immer mehr verschwimmt, besteht außerdem die Gefahr, dass Nutzer spielerische oder satirische Antworten als sachliche Informationen missverstehen. In einem digitalen Zeitalter, in dem jede Information analysiert und weitergegeben wird, könnten die Folgen solcher Fehleinschätzungen weitreichend sein. Vor allem, wenn mehr als eine Sprache ins Spiel kommt.

Auch wenn Humor und Witz ihren Platz haben, ist es wichtig, ein Gleichgewicht zu finden, vor allem wenn die Nutzer nach kritischen Erkenntnissen suchen. Wenn man dem Humor den Vorrang vor der Genauigkeit einräumt, mag das unterhaltsam sein, aber es untergräbt auch den Kern dessen, was ein LLM bieten sollte: verlässliche Informationen.

Overpromised and underdelivered

Elon Musks große Versprechungen in Bezug auf Grok haben die Voraussetzungen für himmelhohe Erwartungen geschaffen. Bei näherer Betrachtung zeigt sich ein mögliches Missverhältnis zwischen dem Hype und der Realität. Die Tatsache, dass herkömmliche LLM-Trainingsmethoden durch ihre Trainingsdaten eingeschränkt sind, unterstreicht eine entscheidende Einschränkung: Sie können sich nicht wirklich in das Gebiet der „Super-KI“ vorwagen.

Das Training von Grok mit seinen 33 Milliarden Parametern und ein paar Monaten Entwicklungszeit wirkt im Vergleich zu anderen LLM-Giganten wie ein Zwerg. Die Idee einer spielerischen, fiktiven Persönlichkeit klingt zwar verlockend, doch die Erwartung, dass sie mit Standardtrainingsmethoden bahnbrechende Ergebnisse liefert, ist vielleicht etwas hoch gegriffen.

Übertreibungen sind der KI-Gemeinschaft nicht fremd, aber angesichts der rasanten Fortschritte in diesem Bereich ist es für die Nutzer wichtig, den Hype zu durchschauen. Den Status einer „Super-KI“ zu erreichen, ist eine gewaltige Herausforderung, und es ist unwahrscheinlich, dass Grok mit seiner derzeitigen Konfiguration und seinem Training dazu in der Lage ist.

Um die Leistungsfähigkeit von Grok zu beweisen, verglich Elon Musk seinen Chatbot mit einem kleinen LLM, der für das Programmieren ausgebildet wurde. Es genügt zu sagen, dass es kein fairer Kampf war.

Beispiel für Grok vs. typischen GPT, wobei Grok aktuelle Informationen hat, der andere aber nicht pic.twitter.com/hBRXmQ8KFi

– Elon Musk (@elonmusk) November 5, 2023

Die Bedrohung durch Fehlinformationen

LLMs sind mächtig, aber sie sind nicht unfehlbar. In Ermangelung strenger Standards wird die Unterscheidung von Fakten und Fiktion zu einer Herkulesaufgabe. Die jüngste Geschichte bietet abschreckende Beispiele, wie Chatbots, die auf der Grundlage von 4chan-Daten trainiert wurden, oder sogar Tay, ein früher Chatbot von Microsoft, der auf Twitter interagieren durfte. Diese Bots verbreiteten nicht nur Hassreden, sondern gaben sich auch überzeugend als echte Personen aus und täuschten so ein großes Online-Publikum.

Diese Woche wurde auf @huggingface ein AIModell veröffentlicht, das verletzende und diskriminierende Texte produziert und bereits mehr als 30.000 abscheuliche Kommentare online gestellt hat (sagt sein Autor).

Dieses Experiment würde niemals eine Ethik-Kommission für Humanforschung passieren. Hier sind meine Empfehlungen.

1/7 https://t.co/tJCegPcFan pic.twitter.com/Mj7WEy2qHl

– Lauren Oakden-Rayner ️⚧️ (@DrLaurenOR) June 6, 2022

Dieser Flirt mit Fehlinformationen ist kein Einzelfall. Da das Image von Twitter seit der Übernahme durch Elon Schaden genommen hat, gibt es möglicherweise Bedenken hinsichtlich der Fähigkeit von Grok, durchgängig korrekte Informationen zu liefern. LLMs fallen gelegentlich Halluzinationen zum Opfer, und wenn diese Verzerrungen als Wahrheiten konsumiert werden, können die Welleneffekte alarmierend sein.

Das Potenzial für Fehlinformationen ist eine tickende Zeitbombe. Da sich die Nutzer zunehmend auf KI stützen, um Erkenntnisse zu gewinnen, können Fehlinformationen zu fehlerhaften Entscheidungen führen. Damit Grok ein vertrauenswürdiger Verbündeter sein kann, muss es vorsichtig vorgehen und sicherstellen, dass sein spielerisches Auftreten nicht die Wahrheit verdunkelt.

Fehlende multimodale Fähigkeiten?

In der aufkeimenden Welt der KI wirkt der reine Textansatz von Grok wie ein Relikt der Vergangenheit. Zwar wird von den Nutzern erwartet, dass sie für die Dienste von Grok bezahlen, aber sie könnten sich zu Recht fragen, warum, insbesondere wenn andere LLMs reichhaltigere, multimodale Erfahrungen anbieten.

GPT-4-v beispielsweise hat bereits Fortschritte im Bereich der Multimodalität gemacht und kann hören, sehen und sprechen. Googles kommendes Gemini verspricht eine ähnliche Reihe von Funktionen. Vor diesem Hintergrund erscheinen die Angebote von Grok eher glanzlos und werfen weitere Fragen zu ihrem Wertversprechen auf.

Der Markt ist hart umkämpft, und die Nutzer werden immer anspruchsvoller. Wenn Grok sich eine Nische erobern will, muss es etwas wirklich Außergewöhnliches bieten. In Anbetracht der Tatsache, dass die Konkurrenz erweiterte Funktionen und eine bessere Genauigkeit anbietet – oft sogar kostenlos -, hat Grok eine Menge Arbeit vor sich.

Abschluss

Der Start von Grok hat Begeisterung ausgelöst, aber auch eine gewisse Skepsis hervorgerufen. Der MVP-Ansatz (Minimum Viable Product) ermöglicht eine schnelle Iteration und Verbesserung auf der Grundlage von Nutzerfeedback. Doch die Konkurrenz von KI-Giganten, die über weitaus mehr Ressourcen verfügen, ist ein harter Brocken.

Um erfolgreich zu sein, muss Grok sowohl neuartige als auch nützliche Funktionen bieten. Ein reiner Unterhaltungswert wird in einem überfüllten Markt nicht ausreichen. Die KI-Leute lassen sich nicht von niedlichen Hundememes ablenken.

Letztendlich hängt das Schicksal von Grok von der Balance zwischen Innovation und Nützlichkeit ab. Auch wenn eine gesunde Skepsis angebracht ist, wäre es voreilig, das Unternehmen komplett abzuschreiben. Grok könnte noch neue Wege gehen oder als Fußnote in der Entwicklung der KI enden. So oder so, seine unkonventionellen Ursprünge garantieren, dass Grok ein faszinierendes Kapitel in der sich entfaltenden Geschichte der künstlichen Intelligenz sein wird.