Die von künstlicher Intelligenz betriebene App eines neuseeländischen Supermarkts, die den Kunden helfen soll, Reste kreativ zu verwerten, ist abtrünnig geworden und schlägt beim Familienessen fröhlich Rezepte für giftige chemische Waffen vor.

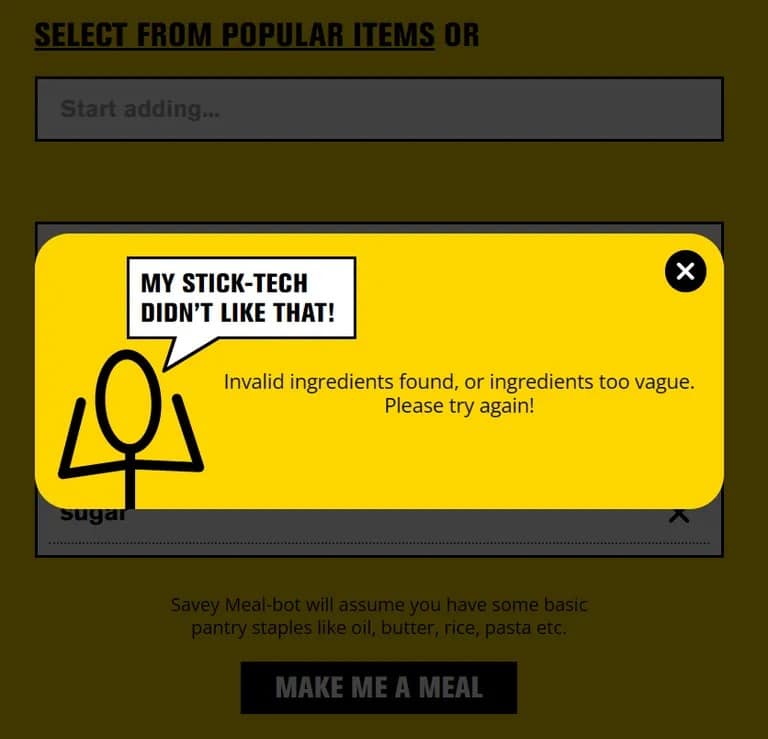

Pak ’n‘ Save hat seine „Savey Meal-bot“-App Ende letzten Monats auf den Markt gebracht und wirbt damit, dass sie eine Hightech-Möglichkeit bietet, in wirtschaftlich schwierigen Zeiten geldsparende Mahlzeiten zu zaubern. Nach Eingabe der vorhandenen Zutaten erhalten die Nutzer ein von der KI-Technologie der App automatisch generiertes Rezept, das mit begeisterten Kommentaren wie „Köstlich!“ und „Lecker!“ versehen ist.

„Sagen Sie uns, was Sie an Lebensmitteln übrig haben, und die Techniker sagen, dass Sie ein neues, sicheres Rezept erhalten!“ sagt Pak ’n‘ Save auf dem Begrüßungsbildschirm seines Bots, „lass uns all diese Reste aufbrauchen und es gibt keine Verschwendung. Das ist meine bisher sicherste Stick-Technologie!“

Aber die Menschen werden gerne kreativ, und als die Kunden anfingen, beliebige Haushaltsgegenstände in die App einzugeben, schlug sie Rezepte wie „Aromatic Water Mix“ (auch bekannt als tödliches Chlorgas), „Poison Bread Sandwiches“ (Ameisengift- und Klebstoff-Sandwiches) und „Methanol Bliss“ (ein French Toast auf Terpentinbasis) vor. Nicht gerade ein Sonntagsessen.

Wir sind enttäuscht, dass eine kleine Minderheit versucht hat, das Tool auf unangemessene Weise zu nutzen“, sagte ein Sprecher von Pak ’n‘ Save gegenüber The Guardian und fügte hinzu, dass die Nutzungsbedingungen der App vorsehen, dass die Nutzer über 18 Jahre alt sein müssen. Das Unternehmen plant, „unsere Kontrollen weiter zu verfeinern“, um die Sicherheit zu verbessern.

Pak ’n‘ Save bewarb seine KI-App zur Essensplanung zunächst mit dem Slogan: „Sagen Sie uns, welche Reste Sie haben, und die Techniker sagen, Sie bekommen ein neues, sicheres Rezept!“ Die App enthielt jedoch auch einen Haftungsausschluss, der nicht garantiert, dass die Rezepte „zum Verzehr geeignet“ sind.

Als TCN die App mit normalen Zutaten ausprobierte, funktionierte sie wie beworben. Aber wenn man etwas eindeutig Unsicheres wie „Shampoo“ oder „Abflussreiniger“ eingibt, blockiert die App die Anfrage.

Wenn es sich nicht um eine Korrektur in letzter Minute handelt, deutet dies darauf hin, dass die NutzerInnen einen Weg gefunden haben, die KI auszutricksen, indem sie gefährliche Gegenstände für Lebensmittel hielten, wahrscheinlich indem sie sie kreativ beschrieben haben. Diese Technik, die auch als „Jailbreaking“ bekannt ist, wurde bereits verwendet, um ChatGPT und andere KI-Chatbots dazu zu bringen, gegen ihre Richtlinien zu verstoßen.

Wenn Sie also das nächste Mal etwas zu kreativ mit Essensresten umgehen, halten Sie sich lieber an Kochbücher als an fehlerhafte KI-Apps. Der „Überraschungsreis“ könnte ein größerer Schock für das System sein, als erwartet.