Los entusiastas de la inteligencia artificial prefieren trabajar con herramientas de código abierto a las comerciales patentadas, según una encuesta realizada a más de 100.000 encuestados.

La aparición del Mixtral 8x7B de Mistral AI, un modelo de código abierto, ha tenido un impacto significativo en el espacio de la IA. Ligero y potente, TCN lo nombró entre los Mejores LLM de 2023. Mixtral ha ganado mucha atención por su notable rendimiento en varias pruebas de referencia, especialmente Chatbot Arena, que ofrece un enfoque único centrado en los humanos para evaluar los LLM.

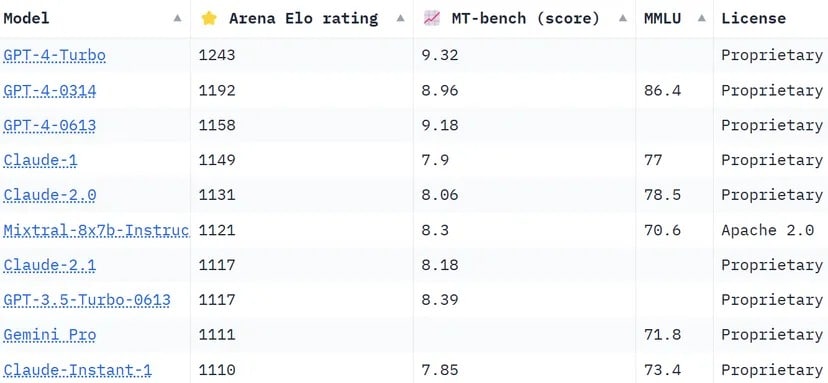

Las clasificaciones de Chatbot Arena, una lista de crowdsourcing, aprovechan los votos de más de 130.000 usuarios para calcular las clasificaciones Elo de los modelos de IA. En comparación con otros métodos que intentan estandarizar los resultados para ser más objetivos, la arena opta por un enfoque más «humano», pidiendo a la gente que elija a ciegas entre dos respuestas proporcionadas por LLMS no identificados. Estas respuestas pueden parecer poco convencionales según ciertos estándares, pero pueden ser evaluadas intuitivamente por usuarios humanos reales.

Mixtral tiene una posición impresionante, superando a gigantes del sector como Claude 2.1 de Anthropíc, GPT-3.5 de OpenAI, que impulsa la versión gratuita de ChatGPT y Gemini de Google, un LLM multimodal que se vendió como el chatbot más potente para desafiar el dominio de GPT-4.

Clasificación de Chatbot Arena. LLM, de Mistral AI, ocupa el sexto puesto de la lista. Imagen: Huggingface

Una de las diferencias notables de Mixtral es ser el único LLM de código abierto en el top 10 de Chatbot Arena. Esta distinción no es sólo una cuestión de clasificación; representa un cambio significativo en la industria de la IA hacia modelos más accesibles e impulsados por la comunidad. Tal y como informa TCN, Mistral AI afirma que su modelo «supera a LlaMA 2 70B en la mayoría de los puntos de referencia con una inferencia 6 veces más rápida e iguala o supera a GPT 3.5 en la mayoría de los puntos de referencia estándar», como MMLU, Arc-C o GSM.

El secreto del éxito de Mixtral reside en su arquitectura de «Mezcla de Expertos» (MoE). Esta técnica emplea múltiples modelos de expertos virtuales, cada uno especializado en un tema o campo distinto. Cuando se enfrenta a un problema, Mixtral selecciona a los expertos más relevantes de su grupo, lo que da lugar a resultados más precisos y eficientes.

En cada capa, para cada token, una red de enrutadores elige dos de estos grupos (los «expertos») para procesar el token y combinar sus resultados de forma aditiva», explica Mistral en el artículo publicado recientemente por el LLM. «Esta técnica aumenta el número de parámetros de un modelo a la vez que controla el coste y la latencia, ya que el modelo sólo utiliza una fracción del conjunto total de parámetros por token».

Además, Mixtral destaca por su competencia multilingüe. El modelo destaca en idiomas como el francés, el alemán, el español, el italiano y el inglés, lo que demuestra su versatilidad y amplio potencial. Su naturaleza de código abierto, bajo licencia Apache 2.0, permite a los desarrolladores explorar, modificar y mejorar libremente el modelo, fomentando un entorno colaborativo e innovador.

Está claro que el éxito de Mixtral no es sólo una cuestión de destreza tecnológica, sino que supone una pequeña pero importante victoria para la comunidad de la IA de código abierto. Tal vez, en un futuro no muy lejano, la cuestión no sea qué modelo fue el primero, o cuál tiene más parámetros o capacidades contextuales, sino cuál resuena realmente entre la gente.