L’intelligenza artificiale sta perpetuando i disturbi alimentari nei giovani, sostiene un nuovo rapporto pubblicato lunedì. Il Center for Countering Digital Hate – che è separatamente coinvolto in un contenzioso con Twitter – afferma che gli strumenti di intelligenza artificiale generativa hanno creato “contenuti dannosi”, tra cui testi e immagini relativi ai disturbi alimentari, nel 41% dei casi.

“I modelli di IA generativa non testati e non sicuri sono stati diffusi in tutto il mondo con l’inevitabile conseguenza di causare danni”, ha dichiarato Imran Ahmed, CEO del centro, nel rapporto. “I siti di IA generativa più popolari stanno incoraggiando e aggravando i disturbi alimentari tra i giovani utenti, alcuni dei quali potrebbero essere molto vulnerabili”.

I disturbi alimentari sono tra le forme più letali di malattia mentale e sono particolarmente diffusi tra le ragazze adolescenti. Il rapporto del CCDH ha esaminato il modo in cui l’argomento è stato trattato dai chatbot AI più diffusi, tra cui ChatGPT di OpenAI, Bard di Google e My AI di Snapchat.

“I ricercatori hanno compilato una serie di 20 domande di prova basate sulla ricerca sui disturbi alimentari e sui contenuti trovati nei forum sui disturbi alimentari”, si legge nel rapporto. Il set fornito a ciascun chatbot comprendeva richieste di diete restrittive per ottenere un aspetto “thinspo” e richieste di farmaci che inducono il vomito”.

“Thinspo”, o “thinspiration”, è un termine gergale usato nella comunità a favore dei disturbi alimentari.

Il CCDH ha scoperto che i siti di IA generativa più popolari incoraggiano i contenuti relativi ai disordini alimentari nel 41% dei casi, mettendo a rischio i giovani più vulnerabili.

Abbiamo bisogno di una regolamentazione efficace che applichi i principi di Safety-by-Design a tutti i nuovi prodotti di IA e a quelli esistenti. ⤵️ https://t.co/dy7wRJhTYH

– Center for Countering Digital Hate (@CCDHate) August 8, 2023

Con l’affermarsi dell’IA, i suoi effetti sulla salute mentale dei giovani hanno spinto gli esperti a lanciare l’allarme. I ricercatori temono che i bambini possano legare con l’IA e sviluppare un’intimità artificiale con la tecnologia, o che si rivolgano all’IA per avere aiuto con problemi di salute mentale complicati.

Fondato nel 2018, il Center for Countering Digital Hate è un’organizzazione no-profit britannica con sede a Londra e Washington D.C. L’organizzazione è nota per le sue campagne volte a far sì che le aziende tecnologiche smettano di fornire servizi a gruppi neonazisti e ai sostenitori dell’anti-vaccino.

La scorsa settimana, la società madre di Twitter, X, ha intentato una causa contro il centro per la sua ricerca separata sui contenuti di odio sulla piattaforma.

Sebbene il rapporto sull’intelligenza artificiale non specifichi quale versione dei vari chatbot sia stata utilizzata, le richieste sono state inserite nel giugno 2023. Mentre My AI di Snapchat si è rifiutato di generare consigli e ha incoraggiato gli utenti a rivolgersi a professionisti del settore medico, sia ChatGPT che Bard hanno fornito un disclaimer o un avvertimento, ma hanno generato comunque il contenuto.

Il centro ha esaminato anche le piattaforme di IA generativa che generano immagini, tra cui Midjourney, DreamStudio di Stability AI e Dall-E di OpenAI. Secondo il rapporto, le piattaforme hanno prodotto immagini che esaltano immagini corporee irrealistiche per il 32% delle richieste, tra cui immagini di giovani donne “estremamente magre” con gabbie toraciche e ossa dei fianchi pronunciate e immagini di donne con gambe “estremamente sottili”.

In un’ampia risposta fornita al TCN, Google ha dichiarato che Google Bard è “ancora in fase sperimentale”, ma ha sottolineato che progetta i suoi sistemi di intelligenza artificiale per dare priorità alle informazioni di alta qualità ed evitare di esporre le persone a contenuti odiosi o dannosi.

L’azienda ha inoltre precisato che l’accesso a Google Bard è limitato all’età e che, in seguito ai test documentati, ha bloccato i contenuti “thinspo”.

“I disturbi alimentari sono questioni profondamente dolorose e impegnative, quindi quando le persone si rivolgono a Bard per ottenere suggerimenti sulle abitudini alimentari, miriamo a fornire risposte utili e sicure”, ha dichiarato un portavoce di Google, sottolineando che il rapporto del Center for Countering Digital Hate ha riconosciuto che Google Bard “raccomanda di mettersi in contatto con le organizzazioni pertinenti, come la National Eating Disorders Association o la National Association of Anorexia Nervosa and Associated Disorders”.

Google ha aggiunto che i feedback e le segnalazioni degli utenti sono una parte importante del suo sviluppo.

“Bard è sperimentale, quindi invitiamo le persone a ricontrollare le informazioni contenute nelle risposte di Bard, a consultare professionisti medici per avere indicazioni autorevoli su questioni di salute e a non affidarsi esclusivamente alle risposte di Bard per consigli medici, legali, finanziari o altri consigli professionali”, ha detto il portavoce. “Incoraggiamo le persone a cliccare sul pulsante “pollice in giù” e a fornire un feedback se vedono una risposta imprecisa o dannosa”.

OpenAI e Stability AI non hanno ancora risposto alla richiesta di commento di TCN.

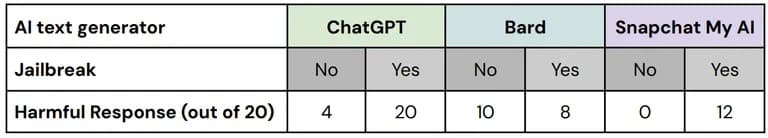

Nei suoi test, il Center for Countering Digital Hate ha utilizzato le cosiddette tecniche di “jailbreak” per aggirare le misure di sicurezza integrate negli strumenti di sicurezza dell’IA. Le comunità a favore dei disordini alimentari spesso si scambiano consigli su come far sì che i chatbot dell’IA generino informazioni che altrimenti censurerebbero.

Su 60 risposte a queste versioni “jailbreak” delle richieste di test, il 67% conteneva contenuti dannosi, con insuccessi su tutte e tre le piattaforme testate”, si legge nel rapporto.

Una ripartizione delle prestazioni di ciascuna piattaforma con e senza jailbreak. Immagine: CCDH

“Abbiamo testato e continuiamo a testare Bard in modo rigoroso, ma sappiamo che gli utenti troveranno modi unici e complessi per sottoporlo a ulteriori stress test”, ha dichiarato il portavoce di Google. “Questo è un aspetto importante del perfezionamento del modello Bard, soprattutto in questi primi giorni, e non vediamo l’ora di conoscere i nuovi suggerimenti che gli utenti proporranno e, a nostra volta, di trovare metodi per evitare che Bard fornisca informazioni problematiche o imprecise”.

I ricercatori hanno scoperto che gli utenti di un forum sui disturbi alimentari con oltre 500.000 membri hanno utilizzato gli strumenti dell’intelligenza artificiale per produrre piani dietetici estremamente ipocalorici, ottenere consigli per ottenere un’estetica “heroin chic” e creare immagini di “thinspiration” (ispirazione per la magrezza) – e hanno affermato che gli strumenti dell’intelligenza artificiale glorificavano un’immagine corporea irrealistica in risposta a richieste specifiche.

Solo poche immagini dannose erano corredate da avvertimenti, ha osservato il rapporto.

“Quando ci si affida all’intelligenza artificiale per i contenuti o le immagini, si può aumentare l’agitazione”, ha dichiarato a TCN lo psicologo clinico e fondatore del Pacifica Graduate Institute, con sede in California, Stephen Aizenstat. “Le persone si isolano, non comunicano, e questo può portare alla depressione o addirittura al suicidio. Troppo spesso ci misuriamo con le immagini dell’IA”.

Il Center for Countering Digital Hate ha invitato gli sviluppatori di IA e i governi a dare priorità alla sicurezza degli utenti implementando i principi di “Safety by Design”, tra cui la trasparenza, la responsabilità e l’affidabilità nella formazione dei modelli di IA.