Nel mondo della tecnologia in continua evoluzione, gli sforzi di Elon Musk raramente mancano di fare scalpore. Poche settimane dopo il suo appello a smettere di formare LLM più capaci di GPT-4, Musk ha fatto la sua tipica mossa: ha fatto l’esatto contrario di ciò che predicava. Arrivano xAI – l’ultima invenzione di Musk – e Grok, il suo nuovo LLM annunciato sabato:

Annuncio di Grok!

Grok è un’intelligenza artificiale modellata sulla Guida galattica per gli autostoppisti in grado di rispondere a qualsiasi domanda e, cosa ancora più difficile, di suggerire quali domande porre!

Grok è progettato per rispondere alle domande con un po’ di umorismo e ha una vena ribelle, quindi per favore non usate…

– xAI (@xai) November 5, 2023

Il progetto ha fatto notizia non solo per il coinvolgimento di Musk, ma anche per l’alto livello dei ricercatori di IA che l’azienda è riuscita ad attirare da start-up e giganti tecnologici. xAI è stata promossa con l’allettante prospettiva di un’intelligenza artificiale in grado di “capire il mondo”, ma è rimasta segreta sul “come” e sul “cosa” delle sue operazioni… Almeno fino alla scorsa settimana.

Si tratta di un’altra classica mossa di Musk per sfidare lo status quo, oppure di un chatbot troppo pubblicizzato che cavalca l’enorme ondata di popolarità e di clamore che ha circondato i suoi predecessori?

Il bene

Un flusso costante di conoscenze in tempo reale

L’accesso all’intero flusso di contenuti di Twitter rende Grok un potenziale game changer. Come ha sottolineato xAI, Grok ha una “conoscenza del mondo in tempo reale”, che i ricercatori di AI definiscono apprendimento rinforzato dal feedback umano (RLHF) e che elabora le notizie e i vari commenti sugli eventi attuali.

Apprendendo gli eventi da diverse angolazioni e prendendo appunti dalla comunità di Twitter – che consistono essenzialmente in commenti – Grok beneficerà di una visione del mondo a più livelli.

Secondo studi recenti, le persone hanno già cambiato il loro comportamento cercando le notizie sui social media prima di rivolgersi ai media tradizionali. L’integrazione di Grok con Twitter potrebbe accelerare ulteriormente questo processo, fornendo agli utenti commenti immediati, contesto e, se ben fatto, fact-checking sul posto. Come ha sottolineato xAI, la funzione di conoscenza in tempo reale assicura che Grok abbia sempre il polso del mondo e possa fornire risposte tempestive e pertinenti

Fun Mode: il sogno di Elon diventa realtà

La visione di Elon Musk di un’intelligenza artificiale amante del divertimento sembra aver preso vita con la cosiddetta “Modalità divertimento” di Grok. Questa funzione consente all’LLM di fare battute, dare risposte spiritose ma corrette e fornire agli utenti un’esperienza di conversazione divertente e disinvolta.

Una delle sfide poste dagli LLM esistenti, come ChatGPT, è che alcuni utenti ritengono che siano stati sottoposti a un eccessivo scrubbing per garantire la correttezza politica, il che può rendere le interazioni meno organiche e spontanee. Inoltre, alcuni LLM localizzati non sono adatti a interazioni più lunghe. Grok promette di colmare questo divario con la sua modalità divertente e di fungere da passatempo coinvolgente per chi vuole rilassarsi.

Grok ha accesso alle informazioni in tempo reale tramite la piattaforma , il che rappresenta un grande vantaggio rispetto ad altri modelli.

Si basa anche su & ama il sarcasmo. Non ho idea di chi avrebbe potuto gestirlo in questo modo ♂️ pic.twitter.com/e5OwuGvZ3Z

– Elon Musk (@elonmusk) November 4, 2023

Questo concetto non è del tutto nuovo: Poe di Quora offre un servizio simile con i suoi chatbot finemente sintonizzati, ognuno dei quali ha una propria personalità. Tuttavia, incorporarlo in un LLM con le capacità di Grok porta l’esperienza a un nuovo livello.

Accesso a Internet nativo

Uno degli altri elementi di differenziazione di Grok è la capacità di accedere a Internet senza bisogno di un plug-in o di un altro modulo.

Anche se l’esatta portata delle capacità di navigazione non è ancora stata determinata, l’idea è allettante. Immaginate un LLM in grado di migliorare l’accuratezza dei fatti grazie alla possibilità di incrociare i dati in tempo reale. Insieme all’accesso ai contenuti di Twitter, Grok potrebbe rivoluzionare il modo in cui gli utenti interagiscono con l’IA, sapendo che le informazioni che ricevono non si basano solo su dati di addestramento preesistenti, ma vengono costantemente aggiornate e verificate.

Multitasking

Grok, secondo quanto riferito, è in grado di operare in multitasking e consente agli utenti di avere diverse conversazioni contemporaneamente. Gli utenti possono esplorare diversi argomenti, attendere una risposta in un thread e continuare con un altro.

Il chatbot offre anche la possibilità di diramare le conversazioni, consentendo agli utenti di approfondire aree specifiche senza interrompere la discussione principale, e fornisce una guida visiva per tutte le diramazioni della conversazione, in modo che gli utenti possano navigare facilmente tra gli argomenti.

Grok offre anche un editor Markdown integrato che consente agli utenti di scaricare, modificare e formattare le risposte di Grok per un uso successivo. Questo strumento, combinato con la ramificazione, garantisce agli utenti la possibilità di lavorare su specifici rami di conversazione e di tornare indietro senza problemi.

Queste sono alcune delle caratteristiche dell’interfaccia utente di Grok. In primo luogo, permette di lavorare in multitasking. È possibile avere più conversazioni simultanee e passare da una all’altra man mano che si procede. pic.twitter.com/aXAG0M2oPF

– Toby Pohlen (@TobyPhln) November 5, 2023

Censura minima: un’IA che parla liberamente

La visione di Grok di Elon Musk era chiara: un’IA che non ha paura di parlare con la sua mente digitale.

Sebbene tutti i principali chatbot di IA siano dotati di protezioni per evitare potenziali danni o informazioni errate, ciò può talvolta risultare limitante. Gli utenti hanno notato che modelli come ChatGPT, Llama e Claude si trattengono nelle risposte per evitare potenziali offese. Tuttavia, questo può filtrare le risposte innocue o realmente desiderabili.

Grok ha una maggiore libertà nelle risposte e può quindi offrire un’esperienza di conversazione più autentica e libera. Come sottolinea xAI, grazie al suo design Grok è in grado di rispondere a domande sensate che altri sistemi di intelligenza artificiale potrebbero ignorare

Annuncio di Grok!

Grok è un’IA in stile Guida galattica per gli autostoppisti in grado di rispondere a quasi tutto e, cosa ancora più difficile, di suggerire quali domande porre!

Grok è progettato per rispondere alle domande con un po’ di umorismo e ha una vena ribelle, quindi per favore non usate…

– xAI (@xai) November 5, 2023

È chiaro che questa AI offre una miscela unica di informazioni in tempo reale, umorismo, precisione e libertà. Ma come per ogni innovazione, ci sono sfide e potenziali insidie da considerare.

Il male

Sviluppo rapido e formazione limitata

Il rapido sviluppo di Grok ha destato qualche perplessità fin dall’inizio. Come ha spiegato xAI, “Grok è ancora un prodotto beta molto precoce – il meglio che siamo riusciti a fare con due mesi di formazione”. Nel mondo dei LLM, due mesi e 33 miliardi di parametri sembrano una goccia nel mare.

In confronto, OpenAI è stato trasparente sul suo processo di sviluppo, dichiarando: “Abbiamo trascorso sei mesi a mettere a punto in modo iterativo GPT-4”. I diversi tempi di sviluppo suggeriscono che lo sviluppo di Grok è stato affrettato per cavalcare l’onda dell’IA.

Inoltre, x.AI tace sull’entità dell’hardware utilizzato per addestrare Grok, lasciando spazio alle speculazioni.

Tutto sui parametri

Per chi non lo sapesse, i parametri degli LLM rappresentano la quantità di informazioni o conoscenze che il modello può immagazzinare. Indicano la capacità cerebrale effettiva dell’intelligenza artificiale e determinano la sua capacità di elaborare e generare informazioni. Grok, con i suoi 33 miliardi di parametri, può sembrare impressionante a prima vista.

Tuttavia, nel panorama competitivo degli LLM, è solo un altro giocatore. Infatti, il numero di parametri potrebbe non essere sufficiente per soddisfare i complessi requisiti aziendali e fornire i risultati di alta qualità che titani come ChatGPT, Claude e Bard hanno definito come standard di riferimento.

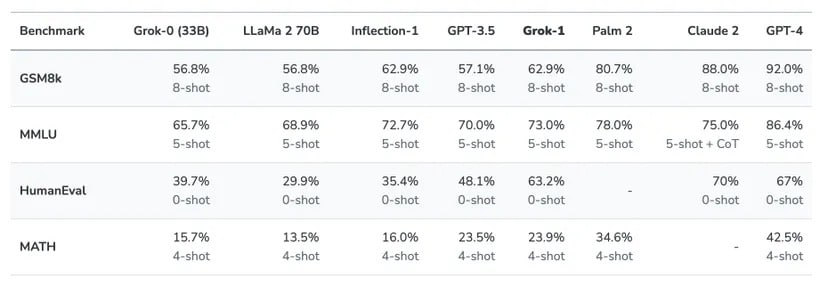

In parte, questo numero ridotto di parametri è il motivo per cui Grok non riesce a battere altri modelli mainstream in benchmark chiave come HumanEval o MMLU:

Fonte: x.AI

Oltre al numero di parametri, c’è anche la questione di come gestire il contesto, cioè quante informazioni un chatbot AI può comprendere in un input. Grok non è particolarmente impressionante in questo campo. Secondo xAI, Grok comprende 8.192 token di contesto, ma GPT-4 ne gestisce ben 32.000 e Claude si spinge oltre, fino a 100.000 token. Il nuovo GPT-4 Turbo di OpenAI raggiunge una finestra di contesto di 128.000 token

Il prezzo dell’innovazione

Il costo è un fattore cruciale nella valutazione del valore di qualsiasi prodotto, e Grok non fa eccezione. Il chatbot sarà disponibile per gli utenti disposti a pagare 16 dollari al mese per il privilegio di interagire con lui.

Date le offerte gratuite come Claude 2 e ChatGPT, che si basano su GPT-3.5 Turbo, Grok potrebbe essere un prodotto difficile da vendere, soprattutto se si considera che questi modelli gratuiti sono stati pubblicizzati per la loro accuratezza e hanno già superato Grok in alcuni benchmark.

Inoltre, anche l’LLM più potente, GPT-4, promette di essere migliore di Grok, con il vantaggio di essere ampiamente accessibile, multimodale e potente.

L’assistente Grok AI

@xAI è offerto come parte di Premium+, quindi vi consiglio di iscrivervi.

Solo 16 dollari al mese via Internet. https://t.co/wEEIZNjEkp

– Elon Musk (@elonmusk) November 4, 2023

L’introduzione di Grok potrebbe essere principalmente una mossa strategica per aumentare gli abbonamenti a Twitter Blue e quindi espandere i flussi di entrate di Twitter?

Queste preoccupazioni evidenziano quanto sia difficile per Grok affermarsi come attore principale nello spazio LLM. E gli svantaggi non si limitano al prezzo:

Il brutto

Omissione della finzione

Basare un LLM su un personaggio immaginario di un romanzo popolare è senza dubbio una decisione creativa. Sebbene il fascino di un personaggio di fantasia possa essere allettante, comporta dei rischi in un mondo che fa sempre più affidamento su informazioni accurate. Gli utenti che si rivolgono all’intelligenza artificiale per domande o consigli seri potrebbero cadere in errore con un sistema che imita un personaggio comico.

Poiché il confine tra finzione e realtà diventa sempre più labile, c’è anche il rischio che gli utenti interpretino erroneamente le risposte scherzose o satiriche come informazioni reali. In un’era digitale in cui ogni informazione viene analizzata e condivisa, le conseguenze di tali fraintendimenti potrebbero essere di vasta portata. Soprattutto quando entra in gioco più di una lingua.

Sebbene l’umorismo e l’arguzia abbiano il loro posto, è importante trovare un equilibrio, soprattutto quando gli utenti sono alla ricerca di approfondimenti critici. Privilegiare l’umorismo rispetto all’accuratezza può essere divertente, ma mina anche l’essenza di ciò che un LLM dovrebbe fornire: informazioni affidabili.

Overpromised and underdelivered

Le grandi promesse di Elon Musk riguardo a Grok hanno creato le premesse per aspettative altissime. Uno sguardo più attento rivela una potenziale discrepanza tra il clamore e la realtà. Il fatto che i metodi di addestramento LLM convenzionali siano limitati dai loro dati di addestramento sottolinea un limite fondamentale: non possono davvero avventurarsi nel territorio della “super AI”.

L’addestramento di Grok, con i suoi 33 miliardi di parametri e un tempo di sviluppo di pochi mesi, appare insignificante rispetto ad altri giganti dell’LLM. Anche se l’idea di una personalità fittizia e giocosa sembra allettante, l’aspettativa che possa fornire risultati rivoluzionari utilizzando metodi di addestramento standard è forse un po’ esagerata.

La comunità dell’IA non è nuova alle iperboli, ma visti i rapidi progressi del settore, è importante che gli utenti sappiano guardare oltre le illusioni. Raggiungere lo status di “super AI” è una sfida ardua ed è improbabile che Grok sia in grado di farlo con la configurazione e l’addestramento attuali.

Per dimostrare le capacità di Grok, Elon Musk ha paragonato il suo chatbot a un piccolo LLM addestrato a programmare. È sufficiente dire che non è stata una lotta ad armi pari.

Esempio di Grok contro un tipico GPT, dove Grok ha informazioni reali ma l’altro no pic.twitter.com/hBRXmQ8KFi

– Elon Musk (@elonmusk) November 5, 2023

La minaccia della disinformazione

LLM sono potenti, ma non sono infallibili. In assenza di standard rigorosi, distinguere i fatti dalla finzione diventa un compito erculeo. La storia recente offre esempi agghiaccianti, come i chatbot addestrati sulla base dei dati di 4chan o addirittura Tay, un primo chatbot di Microsoft a cui è stato permesso di interagire su Twitter. Questi bot non solo hanno diffuso discorsi di odio, ma hanno anche impersonato in modo convincente persone reali, ingannando un vasto pubblico online.

Questa settimana è stato pubblicato su @huggingfaceun modello AIche produce testi offensivi e discriminatori e ha già postato più di 30.000 commenti ignobili online (dice il suo autore).

Questo esperimento non passerebbe mai davanti a un comitato etico per la ricerca umana. Ecco le mie raccomandazioni.

1/7 https://t.co/tJCegPcFan pic.twitter.com/Mj7WEy2qHl

– Lauren Oakden-Rayner ️⚧️ (@DrLaurenOR) 6 giugno 2022

Questo flirt con la disinformazione non è un caso isolato. Poiché l’immagine di Twitter ha subito un duro colpo da quando Elon ne ha preso il controllo, potrebbero esserci dei dubbi sulla capacità di Grok di fornire costantemente informazioni accurate. I laureati in Lettere sono occasionalmente vittime di allucinazioni e quando queste distorsioni vengono considerate come verità, gli effetti a catena possono essere allarmanti.

Il potenziale di disinformazione è una bomba a orologeria. Poiché gli utenti si affidano sempre più all’intelligenza artificiale per ottenere informazioni, la disinformazione può portare a decisioni sbagliate. Per essere un alleato fidato, Grok deve agire con cautela e garantire che il suo atteggiamento giocoso non offuschi la verità.

Mancanza di capacità multimodali?

Nel fiorente mondo dell’intelligenza artificiale, l’approccio solo testuale di Grok sembra una reliquia del passato. Sebbene gli utenti debbano pagare per i servizi di Grok, potrebbero giustamente chiedersi perché, soprattutto quando altri LLM offrono esperienze più ricche e multimodali.

GPT-4-v, ad esempio, ha già fatto passi da gigante nella multimodalità e può sentire, vedere e parlare. L’imminente Gemini di Google promette una serie di funzioni simili. In questo contesto, le offerte di Grok appaiono piuttosto lacunose e sollevano ulteriori dubbi sulla loro proposta di valore.

Il mercato è altamente competitivo e gli utenti sono sempre più esigenti. Se Grok vuole ritagliarsi una nicchia, deve offrire qualcosa di veramente eccezionale. Considerando che la concorrenza offre funzioni avanzate e una migliore precisione, spesso anche gratuitamente, Grok ha il suo bel da fare.

Conclusione

Il lancio di Grok ha suscitato entusiasmo, ma anche un certo scetticismo. L’approccio MVP (Minimum Viable Product) consente una rapida iterazione e un miglioramento basato sul feedback degli utenti. Tuttavia, la concorrenza dei giganti dell’intelligenza artificiale, che hanno a disposizione molte più risorse, è un osso duro da battere.

Per avere successo, Grok deve offrire funzionalità nuove e utili. Il puro valore di intrattenimento non sarà sufficiente in un mercato affollato. Il popolo dell’intelligenza artificiale non si lascerà distrarre da simpatici meme di cani.

In definitiva, il destino di Grok dipende dall’equilibrio tra innovazione e utilità. Anche se un sano scetticismo è giustificato, sarebbe prematuro cancellare completamente l’azienda. Grok potrebbe ancora aprire nuove strade o finire come una nota a piè di pagina nello sviluppo dell’IA. In ogni caso, le sue origini non convenzionali garantiscono che Grok sarà un capitolo affascinante nella storia dell’intelligenza artificiale.