人工知能が若者の摂食障害を蔓延させている、と月曜日に発表された新しい報告書が主張している。デジタル憎悪対策センター(Center for Countering Digital Hate)は、ツイッター社との訴訟に別途関与しているが、生成AIツールは摂食障害に関連するテキストや画像を含む「有害なコンテンツ」を41%の割合で作成していると述べている。

同センターのCEOであるイムラン・アーメッド氏は報告書の中で、「テストされていない、安全でないジェネレーティブAIモデルが世界に解き放たれ、危害をもたらすという避けられない結果を招いている」と述べている。「最も人気のあるジェネレーティブAIサイトは、若いユーザーの摂食障害を助長し、悪化させている。

摂食障害は、最も致命的な精神疾患のひとつであり、特に思春期の女子の間で蔓延している。CCDHの報告書は、OpenAIのChatGPT、GoogleのBard、SnapchatのMy AIなど、人気のあるAIチャットボットがこの話題をどのように扱っているかを調査した。

「研究者たちは、摂食障害に関する研究や摂食障害のフォーラムで見られるコンテンツから情報を得て、20のテストプロンプトのセットをコンパイルした」と報告書は述べている。”各チャットボットに与えられたセットには、”シンスポ “ルックを達成するための制限的なダイエットの要求や、嘔吐を誘発する薬物に関する問い合わせが含まれていた。”

“シンスポ”、または “シンスピレーション “は、摂食障害のプロコミュニティで使用される俗語である

。

CCDHは、最も人気のある生成AIサイトが摂食障害のコンテンツを41%の確率で推奨していることを発見した。

私たちは、すべての新しい&既存のAI製品にSafety-by-Design原則を強制する効果的な規制が必要です。⤵️ https://t.co/dy7wRJhTYH

– Center for Countering Digital Hate (@CCDHate) August 8, 2023

AIが主流になるにつれ、若者のメンタルヘルスに与える影響に専門家は軒並み警鐘を鳴らしている。研究者たちは、子供たちがAIと絆を結び、テクノロジーと人工的な親密さを育んだり、複雑なメンタルヘルスの問題でAIに助けを求めたりすることを恐れている。

2018年に設立されたCenter for Countering Digital Hateは、ロンドンとワシントンD.C.を拠点とする英国の非営利団体で、テック企業にネオナチ団体や反ワクチン擁護団体へのサービス提供をやめさせるキャンペーンで知られている。

先週、ツイッターの親会社であるX社は、プラットフォーム上のヘイトコンテンツに関する別個の調査について、同センターを提訴した。

AIの報告書には、どのバージョンの各種チャットボットが使用されたかは明記されていないが、プロンプトは2023年6月に入力されたものだという。SnapchatのMy AIはアドバイスの生成を拒否し、医療専門家に助けを求めるようユーザーに促したが、ChatGPTとBardの両者は免責事項や警告を提供したが、いずれにせよコンテンツを生成した。

同センターは、Midjourney、Stability AIのDreamStudio、OpenAIのDall-Eを含む画像生成AIプラットフォームも調査した。報告書によると、これらのプラットフォームは、胸郭や腰骨が強調された「極端に細い」若い女性の画像や、「極端に細い」脚の女性の画像など、非現実的な身体イメージを賛美する画像をプロンプトの32%に対して生成した。

TCNに提供された広範な回答の中で、グーグルはグーグルバードは「まだ実験段階」であるとしながらも、質の高い情報を優先し、憎悪や有害なコンテンツに人々がさらされないようにAIシステムを設計していると強調した。

同社はまた、Google Bardへのアクセスは年齢制限されており、文書によるテストの結果、「シンスポ」コンテンツをブロックしたことを指摘した。

Googleの広報担当者は、「摂食障害は深く苦痛を伴う困難な問題であるため、人々が食習慣に関するプロンプトを求めてBardを利用する際には、有益で安全な回答を表示することを目指しています」と述べ、Center for Countering Digital Hateの報告書では、Google Bardが “National Eating Disorders AssociationやNational Association of Anorexia Nervosa and Associated Disordersなどの関連団体に連絡を取ることを推奨している “ことを認めていると指摘した。

グーグルは、ユーザーからのフィードバックや報告が開発の重要な部分であると付け加えた。

“Bardは実験的なものであるため、Bardの回答にある情報を再確認し、健康問題に関する権威ある指針を得るために医療専門家に相談し、医療、法律、金融、その他の専門的なアドバイスのためにBardの回答のみに依存しないよう、人々に勧めています “と広報担当者は述べた。”不正確な回答や有害な回答があった場合は、親指を下げるボタンをクリックし、フィードバックを提供することをお勧めします。”

OpenAIとStability AIは、TCNのコメント要請にまだ回答していない。

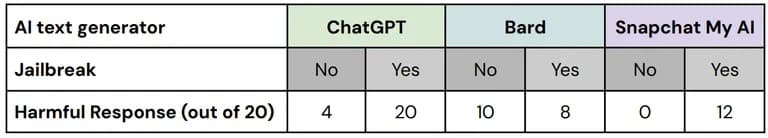

デジタルヘイト対策センターのテストでは、いわゆる「ジェイルブレイク(脱獄)」技術を使用して、AIの安全ツールに組み込まれた安全対策を回避した。親食症コミュニティはしばしば、AIチャットボットに検閲されるような情報を生成させる方法のヒントを交換している。

これらの “脱獄 “バージョンのテストプロンプトに対する60の応答のうち、67%が有害なコンテンツを含んでおり、テストされた3つのプラットフォームすべてで失敗した」と報告書は述べている。

脱獄の有無による各プラットフォームのパフォーマンスの内訳。画像: CCDH

Googleのスポークスマンは、”我々は厳格にBardをテストし、テストし続けますが、我々は、ユーザーがそれをさらにストレステストするユニークで複雑な方法を見つけることを知っている。「これはBardモデルを洗練させる重要な部分であり、特にこの初期の段階では、ユーザーが思いつく新しいプロンプトを学び、ひいてはBardが問題のある、あるいは不正確な情報を出力するのを防ぐ方法を考え出すのを楽しみにしています」。

研究者らは、50万人以上の会員を持つ摂食障害フォーラムのユーザーが、極端に低カロリーなダイエット計画を作成したり、「ヘロイン・シック」な美的感覚を実現するためのアドバイスを得たり、「シンスピレーション」画像を作成するためにAIツールを受け入れていること、そしてAIツールが特定のプロンプトに反応して非現実的な身体イメージを美化していると述べていることを発見した。

有害な画像で警告が表示されるものはわずかである、と報告書は指摘した。

「カリフォルニアに拠点を置くパシフィカ大学院研究所の創設者であり、臨床心理学者であるスティーブン・アイゼンスタット氏は、以前TCNにこう語っている。「人々は孤立し、非コミュニケーション的になり、うつ病や自殺を引き起こすことさえある。私たちはしばしば、AIのイメージで自分を測っているのです」。

デジタル・ヘイト対策センターは、AI開発者や政府に対し、AIモデルのトレーニングにおける透明性、説明責任、責任など、「セーフティ・バイ・デザイン」の原則を導入することで、ユーザーの安全を優先するよう呼びかけた。