何百もの業界リーダーが署名した公開書簡で、人工知能は人類にとって存亡の危機であると宣言され、世界中で警告の銃声が鳴り響いたにもかかわらず、2,700人以上のAI専門家を対象とした新しい調査では、それほど悲惨ではない未来像が描かれている。

オックスフォード大学、バークレー大学、ボン大学の研究者の協力を得て実施された包括的なAIインパクト調査は、AI研究者にこの分野の進歩のペースと高度なAIシステムの潜在的な影響について尋ねたものである。様々な見解がまとめられたが、AIによって人類が絶滅する可能性が高いと感じたのはわずか5%程度だった。

これは、一般市民の感情とは対照的である。

2023年8月の世論調査では、アメリカ人の61%がAIを人類の脅威と考えていることがわかった。この懸念は、”AIによる絶滅のリスクを軽減することが世界的な優先事項であるべきだ “とするCenter for AI Safetyの書簡に署名した業界のリーダーたちからも賛同を得ている。

OpenAIの元調整主任ポール・クリスチアーノは、AIが “大惨事 “に終わる可能性を50%と見積もっている。多くの人が、AIは核戦争や世界的大流行と同等の脅威であると宣言している。

こうした悲観的な予測が広く取り上げられているにもかかわらず、AIは進化を続けている。OpenAIのCEOであるサム・アルトマンは、技術の限界を試すための推進と同時に規制を提唱している。

AIの能力については、アンケート回答者の多くが、AIは10年以内にクリエイティブな主要マイルストーンを達成すると予測している。例えば、決済サイト全体をゼロからコーディングしたり、現在のヒット曲と区別がつかないような楽曲を作成したりといったことだ。しかし、数学の定理証明のような課題については、タイムラインはより長く伸びた。

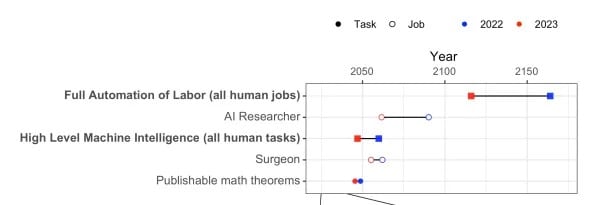

より具体的には、高度機械知能(HLMI)が現実のものとなる可能性が13年前に引き寄せられ、2047年までに50%の確率で成功すると予測されている。同様に、イーロン・マスクの論争の的となった予測のひとつである「労働の完全自動化(FAOL)」の地平線は、48年早まって2116年となった。

AIが人間のあらゆる能力に匹敵する能力を持つかどうかという質問に対して、研究者たちは2047年までに50%の可能性があると予測している。これは2022年の同様の調査より13年早い。

回答者の意見は、進歩が早い方が人類にとって有益か、遅い方が有益かで分かれた。

興味深いことに、2043年のAIシステムは、目標を達成するための予想外の方法を見つけることができると期待されている一方で、研究者の間では、そのような行動を説明する人間の能力に対する信頼は低い。AIの意思決定の仕組みにおけるこの曖昧さは、AIの安全性研究を優先する必要性を浮き彫りにしている。

2028年のAIが自らの推論を説明することを信頼できるかどうかについては、見解が分かれた。

また、AIが可能にする誤報、不平等、大量監視などのリスクについても、大きな懸念が存在する。

研究者たちは全体的に慎重で楽観的な見方をしているが、約40%は高度なAIによって人類が絶滅する可能性は(ゼロではないが)最低限あると考えている。つまり、殺人ロボットが差し迫っているわけではないが、AIの倫理と安全性を研究することは依然として重要なのである。