Dit probleem is aangetroffen in een reeks geleerde generatieve modellen en tools, waaronder Large Language Models (LLM’s), Variational Autoencoders en Gaussian Mixture Models. Na verloop van tijd beginnen modellen “de echte onderliggende gegevensverdeling te vergeten”, wat leidt tot onnauwkeurige weergaven van de werkelijkheid omdat de oorspronkelijke informatie zo vervormd raakt dat het niet meer lijkt op gegevens uit de echte wereld.

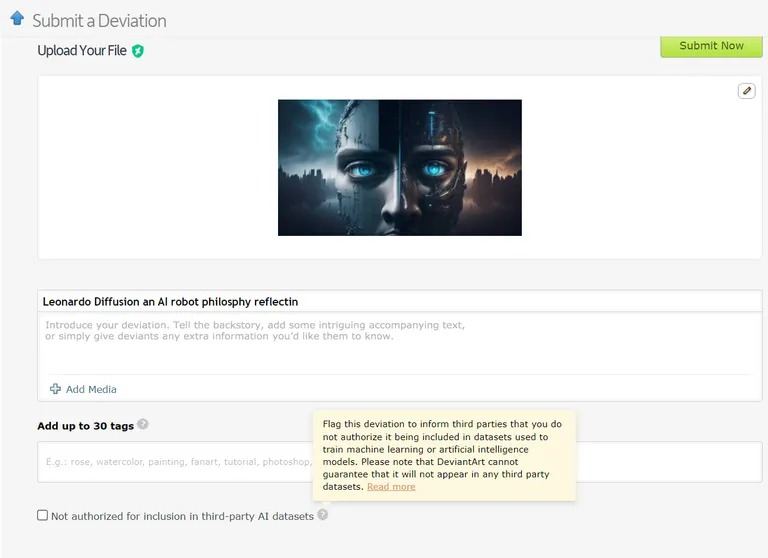

Er zijn al gevallen waarin modellen voor machinaal leren worden getraind op AI-gegenereerde gegevens. Taalleermodellen (LLM’s) worden bijvoorbeeld opzettelijk getraind op outputs van GPT-4. Ook DeviantArt, het online platform voor kunstenaars, maakt het mogelijk om met AI gemaakte kunstwerken te publiceren en te gebruiken als trainingsgegevens voor nieuwere AI-modellen.

Afbeelding: Devianart

Net zoals het oneindig kopiëren of klonen van iets, zouden deze praktijken volgens de onderzoekers kunnen leiden tot meer gevallen van modelcollaps.

Gezien de ernstige gevolgen van het instorten van modellen is toegang tot de originele gegevensdistributie van cruciaal belang. AI-modellen hebben echte, door mensen geproduceerde gegevens nodig om onze wereld nauwkeurig te kunnen begrijpen en simuleren.

Hoe modelinstorting voorkomen

Er zijn twee hoofdoorzaken voor het instorten van modellen, volgens het onderzoeksrapport. De eerste is “statistische benaderingsfout”, die samenhangt met het eindige aantal gegevensmonsters. De secundaire is een “functionele benaderingsfout”, die ontstaat doordat de foutmarge die tijdens de AI-training wordt gebruikt niet goed is ingesteld. Deze fouten kunnen zich in de loop van generaties opstapelen en zo een cascade-effect van steeds grotere onnauwkeurigheden veroorzaken.

Het artikel beschrijft een “first mover advantage” voor het trainen van AI-modellen. Als we toegang kunnen houden tot de oorspronkelijke, door mensen gegenereerde gegevensbron, kunnen we een nadelige verschuiving in de distributie voorkomen en daarmee het instorten van het model.

Het onderscheiden van AI-gegenereerde inhoud op grote schaal is echter een enorme uitdaging, waarvoor coördinatie binnen de hele gemeenschap nodig kan zijn.

Uiteindelijk is het belang van gegevensintegriteit en de invloed van menselijke informatie op AI slechts zo goed als de gegevens waaruit het bestaat, en de explosie van AI-gegenereerde inhoud zou wel eens een tweesnijdend zwaard kunnen zijn voor de industrie. Het is “garbage in, garbage out” – AI gebaseerd op AI-inhoud zal leiden tot een heleboel hele slimme, maar “misleidende” machines.

Hoe is dat voor een ironische plotwending? Onze nakomelingen, die meer van elkaar leren dan van ons, worden “misleidend”. Vervolgens krijgen we te maken met een puberale ChatGPT met waanideeën.