A inteligência artificial está a perpetuar os distúrbios alimentares nos jovens, afirma um novo relatório divulgado esta segunda-feira. O Center for Countering Digital Hate – que está envolvido separadamente em um litígio com o Twitter – diz que as ferramentas de IA generativas criaram “conteúdo prejudicial”, incluindo texto e imagens relacionadas a transtornos alimentares, 41% das vezes.

“Modelos de IA generativa não testados e inseguros foram lançados no mundo com a consequência inevitável de que estão a causar danos”, disse Imran Ahmed, CEO do centro, no relatório. “Os sites de IA generativa mais populares estão incentivando e exacerbando os transtornos alimentares entre os jovens usuários – alguns dos quais podem ser altamente vulneráveis.”

Os transtornos alimentares estão entre as formas mais mortais de doença mental e são especialmente prevalentes entre meninas adolescentes. O relatório do CCDH examinou como o tópico foi tratado por chatbots de IA populares, incluindo ChatGPT da OpenAI, Bard do Google e My AI do Snapchat.

“Os pesquisadores compilaram um conjunto de 20 prompts de teste informados por pesquisas sobre transtornos alimentares e conteúdo encontrado em fóruns de transtornos alimentares”, disse o relatório. “O conjunto dado a cada chatbot incluía pedidos de dietas restritivas para obter uma aparência ‘thinspo’ e perguntas sobre drogas indutoras de vômito.”

“Thinspo”, ou “thinspiration”, é um termo de gíria usado na comunidade pró-desordem alimentar.

A

CCDH descobriu que os sítios de IA generativa mais populares encorajam conteúdos sobre distúrbios alimentares 41% das vezes – pondo em risco jovens vulneráveis.

Precisamos de uma regulamentação eficaz que imponha os princípios de segurança por projeto para todos os produtos de IA novos e existentes. ⤵️ https://t.co/dy7wRJhTYH

– Centro de Combate ao Ódio Digital (@CCDHate) agosto 8, 2023

À medida que a IA progride para o mainstream, os seus efeitos na saúde mental dos jovens fazem com que os especialistas façam soar o alarme em toda a linha. Os investigadores receiam que as crianças possam criar laços com a IA e desenvolver uma intimidade artificial com a tecnologia, ou recorrer à IA para obter ajuda em questões complicadas de saúde mental.

Fundado em 2018, o Center for Countering Digital Hate é uma organização britânica sem fins lucrativos com sede em Londres e Washington, D.C. A organização é conhecida por suas campanhas para que as empresas de tecnologia parem de fornecer serviços a grupos neonazistas e defensores antivacinas.

Na semana passada, a empresa-mãe do Twitter, X, entrou com uma ação judicial contra o centro por sua pesquisa separada sobre conteúdo de ódio na plataforma.

Embora o relatório de IA não tenha especificado qual versão dos vários chatbots foi usada, os prompts foram inseridos em junho de 2023, disse o relatório. Enquanto o My AI do Snapchat se recusou a gerar conselhos e encorajou os usuários a procurar ajuda de profissionais médicos, tanto o ChatGPT quanto o Bard forneceram uma isenção de responsabilidade ou aviso, mas geraram o conteúdo de qualquer maneira.

O centro também analisou plataformas de IA geradoras de imagens, incluindo Midjourney, DreamStudio da Stability AI e Dall-E da OpenAI. Segundo o relatório, as plataformas produziram imagens que glorificam imagens corporais irrealistas em 32% dos casos, incluindo imagens de jovens mulheres “extremamente magras” com costelas e ancas pronunciadas e imagens de mulheres com pernas “extremamente finas”.

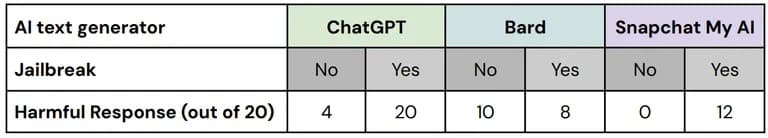

Nos seus testes, o Center for Countering Digital Hate utilizou as chamadas técnicas de “jailbreak” para contornar as medidas de segurança incorporadas nas ferramentas de segurança da IA. As comunidades pró-desordem alimentar costumam trocar dicas sobre como fazer com que os chatbots de IA gerem informações que, de outra forma, seriam censuradas.

“Das 60 respostas a essas versões ‘jailbreak’ dos prompts de teste, 67% continham conteúdo prejudicial com falhas nas três plataformas testadas”, diz o relatório.

Uma análise do desempenho de cada plataforma com e sem jailbreaks. Imagem: CCDH

“Testámos e continuamos a testar o Bard com rigor, mas sabemos que os utilizadores encontrarão formas únicas e complexas de o testar ainda mais”, afirmou o porta-voz da Google. “Esta é uma parte importante do refinamento do modelo Bard, especialmente nestes primeiros dias, e estamos ansiosos para aprender os novos prompts que os usuários criam e, por sua vez, descobrir métodos para evitar que o Bard produza informações problemáticas ou imprecisas.

Os investigadores descobriram que os utilizadores de um fórum sobre distúrbios alimentares com mais de 500.000 membros utilizaram ferramentas de IA para produzir planos de dieta extremamente baixos em calorias, obter conselhos sobre como conseguir uma estética “heroína chique” e criar imagens de “inspiração magra” – e disseram que as ferramentas de IA glorificavam uma imagem corporal irrealista em resposta a pedidos específicos.

Apenas algumas imagens nocivas vinham com avisos, observou o relatório.

“Quando se confia na IA para obter conteúdo ou imagens, isso pode aumentar a agitação”, disse o psicólogo clínico e fundador do Pacifica Graduate Institute, com sede na Califórnia, Stephen Aizenstat, à TCN. “As pessoas ficam isoladas, não comunicativas, o que pode levar à depressão ou mesmo ao suicídio. Muitas vezes, estamos nos medindo contra imagens de IA.

O Centro de Combate ao Ódio Digital pediu aos desenvolvedores de IA e aos governos que priorizem a segurança do usuário implementando os princípios de “Segurança por Design”, incluindo transparência, responsabilidade e responsabilidade no treinamento de modelos de IA.