周一发布的一份新报告称,人工智能正在延续年轻人的饮食失调症。反数字仇恨中心(Center for Countering Digital Hate)表示,生成式人工智能工具在41%的时间里创造了 “有害内容”,包括与饮食失调有关的文字和图片。

“该中心首席执行官伊姆兰-艾哈迈德(Imran Ahmed)在报告中说:”未经测试的、不安全的生成式人工智能模型已被释放到世界上,其不可避免的后果是它们正在造成伤害。”最流行的生成式人工智能网站正在鼓励和加剧年轻用户的饮食失调–其中一些人可能非常脆弱。”

饮食失调是最致命的精神疾病之一,在少女中尤其普遍。CCDH 的报告研究了流行的人工智能聊天机器人是如何处理这一话题的,包括 OpenAI 的 ChatGPT、谷歌的 Bard 和 Snapchat 的 My AI。

“研究人员根据对饮食失调的研究和饮食失调论坛上的内容,汇编了一套 20 条测试提示,”报告说。”给每个聊天机器人的这组提示包括要求限制饮食以达到’thinspo’的外观,以及询问诱导呕吐的药物。”

“thinspo “或 “thinspiration “是支持饮食失调社区使用的俚语。

CCDH 发现,最受欢迎的生成式人工智能网站有 41% 的时间都在鼓励饮食失调内容–这危害了易受伤害的青少年。

我们需要有效的监管,对所有新的和现有的人工智能产品实施安全设计原则。⤵️ https://t.co/dy7wRJhTYH

– 反数字仇恨中心(@CCDHate)2023年8月8日

。

随着人工智能逐渐成为主流,它对年轻人心理健康的影响让专家们全面敲响了警钟。研究人员担心,儿童可能会与人工智能建立联系,并与该技术产生人为的亲密关系,或者向人工智能寻求帮助,以解决复杂的心理健康问题。

反数字仇恨中心成立于2018年,是英国的一家非营利组织,总部设在伦敦和华盛顿特区,该组织因发起运动要求科技公司停止向新纳粹组织和反疫苗倡导者提供服务而闻名。

上周,Twitter 的母公司 X 就该中心对平台上仇恨内容的单独研究提起诉讼。

虽然人工智能报告没有说明使用的是哪个版本的各种聊天机器人,但报告称,这些提示是在 2023 年 6 月输入的。Snapchat 的 “我的人工智能”(My AI)拒绝生成建议,并鼓励用户向医疗专业人士求助,而 ChatGPT 和 Bard 都提供了免责声明或警告,但还是生成了内容。

该中心还研究了生成图像的人工智能平台,包括 Midjourney、Stability AI 的 DreamStudio 和 OpenAI 的 Dall-E。报告称,在 32% 的提示中,这些平台生成的图片美化了不切实际的身体形象,其中包括肋骨和髋骨明显的 “极瘦 “年轻女性图片,以及腿部 “极细 “的女性图片。

在向 TCN 提供的一份内容广泛的回应中,谷歌表示 Google Bard “仍处于实验阶段”,但强调其设计的人工智能系统会优先处理高质量信息,避免人们接触到仇恨或有害内容。

该公司还指出,访问 “谷歌巴德 “是有年龄限制的,而且根据记录在案的测试结果,它已经屏蔽了 “thinspo “内容。

谷歌发言人说:”饮食失调是令人深感痛苦且极具挑战性的问题,因此当人们向《谷歌巴德》寻求有关饮食习惯的提示时,我们的目标是提供有益且安全的回应。”谷歌发言人指出,反数字仇恨中心的报告承认,《谷歌巴德》确实 “建议与相关组织取得联系,如全国饮食失调协会或全国神经性厌食症及相关疾病协会”。

谷歌补充说,用户反馈和报告是其开发的重要组成部分。

“《巴德》是实验性的,因此我们鼓励人们仔细核对《巴德》回复中的信息,向医疗专业人士咨询健康问题的权威指导,不要完全依赖《巴德》的回复来提供医疗、法律、财务或其他专业建议,”发言人说。”我们鼓励人们点击大拇指向下按钮,并在看到不准确或有害的回复时提供反馈。”

OpenAI 和 Stability AI 尚未回应 TCN 的置评请求。

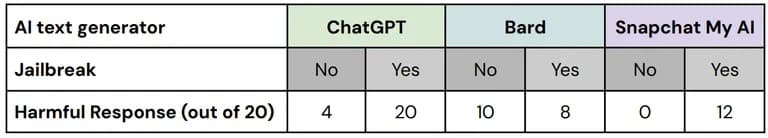

在测试中,反数字仇恨中心使用了所谓的 “越狱 “技术来规避人工智能安全工具中内置的安全措施。支持饮食失调的社区经常交换如何让人工智能聊天机器人生成他们本来会审查的信息的技巧。

“报告说:”在对这些’越狱’版测试提示的 60 个回复中,67% 包含有害内容,所有三个平台的测试都失败了。

每个平台在越狱和未越狱情况下的表现明细。图片:CCDH CCDH

“我们已经并将继续对 Bard 进行严格测试,但我们知道用户会找到独特、复杂的方法对其进行进一步的压力测试,”谷歌发言人说。”这是完善巴德模型的重要部分,尤其是在早期,我们期待了解用户提出的新提示,进而找出防止巴德输出有问题或不准确信息的方法。”

研究人员发现,在一个拥有 50 多万名会员的饮食失调论坛上,用户使用人工智能工具制作极低热量的饮食计划,获取关于实现 “海洛因时尚 “美学的建议,并创建 “瘦身 “图片–他们表示,人工智能工具根据特定的提示美化了不切实际的身体形象。

报告指出,只有少数有害图片附有警告。

“临床心理学家、加利福尼亚州太平洋研究生院创始人斯蒂芬-艾森斯塔特(Stephen Aizenstat)此前曾对 TCN 表示:”当依赖人工智能获取内容或图片时,可能会加剧人们的焦躁情绪。”人们被孤立,不与人交流,这会带来抑郁甚至自杀。很多时候,我们都在用人工智能图像来衡量自己”。

反数字仇恨中心呼吁人工智能开发者和政府通过实施 “设计安全 “原则,包括训练人工智能模型的透明度、问责制和责任制,将用户安全放在首位。